Apple abandona el proyecto de escanear las fotos de iCloud buscando pornografía infantil

By Ángel González

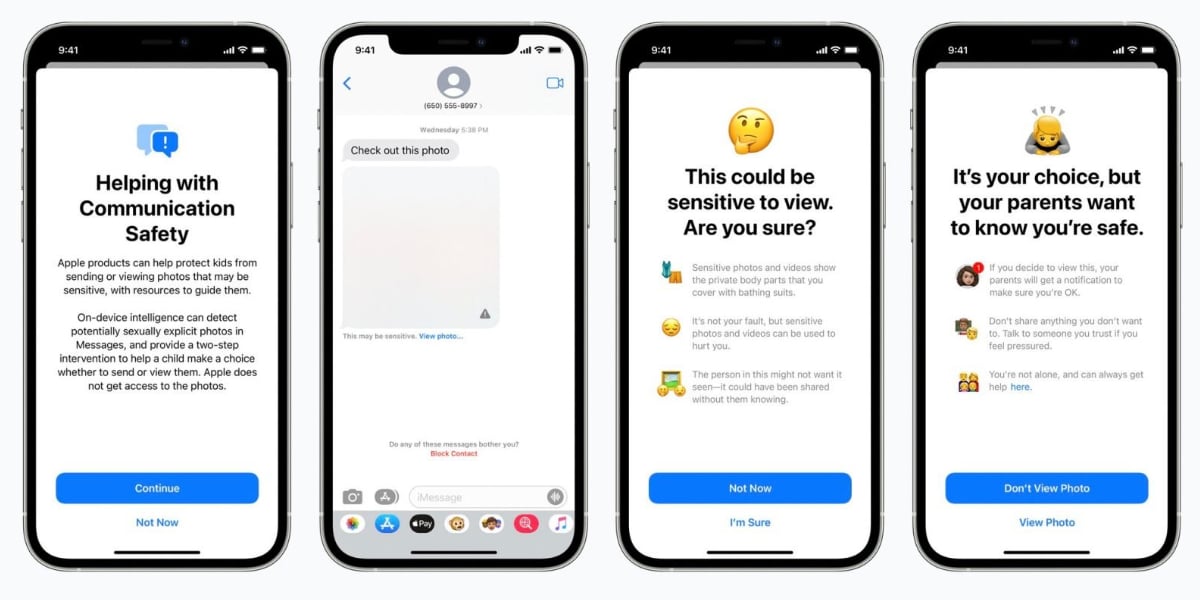

La llegada de iOS 15 trajo consigo un gran repertorio de novedades para proteger a los menores de grandes problemas de hoy en día. De hecho se presentaron tres grandes grupos de funcionalidades. Las dos que hoy en día están disponibles son la seguridad en las comunicaciones dentro de iMessages y, por otro lado, las advertencias en torno a estos temas en Siri, Spotlight y Safari. Sin embargo, la función estrella de Apple era escanear las fotos de iCloud de los usuarios con el objetivo de encontrar pornografía infantil. Tras varios meses pospuesto, el proyecto ha sido abandonado por Apple.

Escáner de fotos en busca de CSAM, el proyecto de Apple

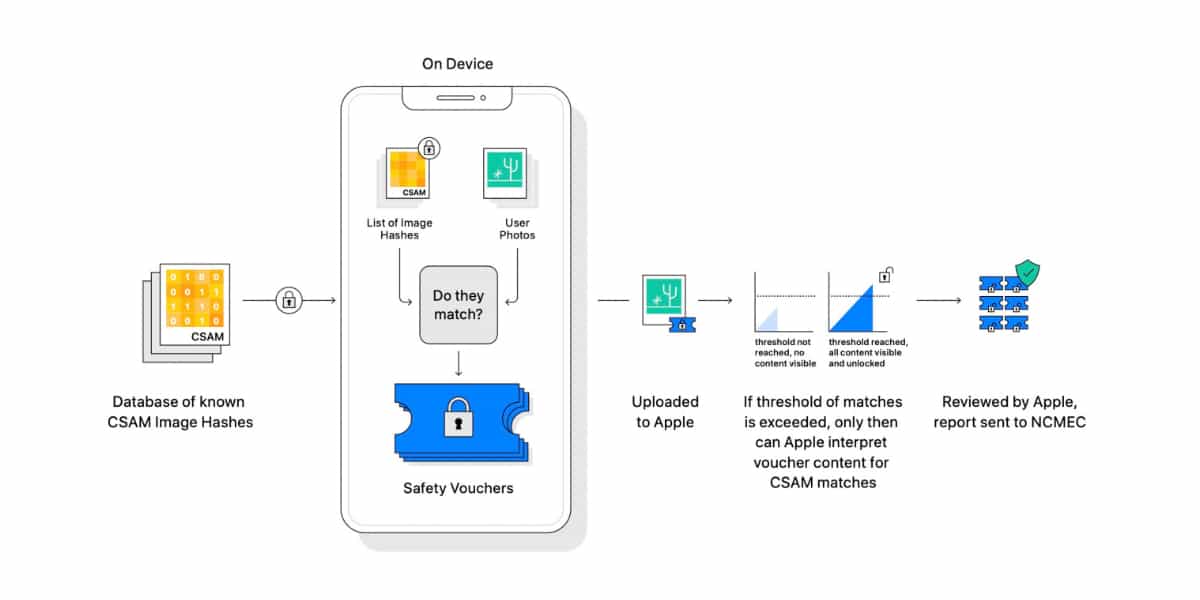

La herramienta estrella de Apple era conocida por su dilema tanto ético como a nivel de privacidad que suscitó cuando se presentó hace ya más de un año. El objetivo de la herramienta de Apple era escanear las fotos de iCloud de los usuarios en busca de pornografía infantil. Este término no es el utilizado de forma oficial sino que el término utilizado era CSAM (Child Sexual Abuse Material o Material de abuso sexual infantil).

Algunas funciones de protección infantil que sí que están disponibles en iOS actualmente

Para ello, los de Cupertino se aliaron con la NCMEC, el Centro Nacional para Menores Desaparecidos y Explotados, de Estados Unidos. Este centro tiene una gran base de datos con imágenes de pornografía infantil o CSAM. Cada una de estas fotos tiene una firma o hash que no varía. Es decir, si una imagen con contenido delicado tiene una misma firma que una que tiene el usuario, saltarán las alarmas.

Apple aseguró que la probabilidad de que se diera una falsa alarma era mínima ya que había que tener más de 30 fotos cuyas firmas o hash fueran idénticas a la base de datos CSAM para que Apple interviniera. Sin embargo, la comunidad tanto tecnológica, como ética y de seguridad así como propios empleados de Apple provocaron una abalancha de críticas que produjeron que se pospusiera la función y no viera la luz en iOS 15.

El proyecto para escanear fotos en busca de pornografía infantil se paraliza

Hace unas horas se publicaba un comunicado de Apple en WIRED donde se anunciaba el abandono del desarrollo de este escáner de fotos de iCloud en busca de pornografía infantil:

Tras una amplia consulta con expertos para recabar opiniones sobre las iniciativas de protección de la infancia que propusimos el año pasado, estamos profundizando nuestra inversión en la función Seguridad de las comunicaciones que pusimos a disposición por primera vez en diciembre de 2021. Además, hemos decidido no seguir adelante con nuestra herramienta de detección de CSAM propuesta anteriormente para Fotos de iCloud. Se puede proteger a los niños sin que las empresas rastreen sus datos personales, y seguiremos trabajando con gobiernos, defensores de la infancia y otras empresas para ayudar a proteger a los jóvenes, preservar su derecho a la privacidad y hacer de Internet un lugar más seguro para los niños y para todos nosotros.

Por lo tanto, Apple abandona un proyecto que inició hace algo más de un año. Todo ello provocado por el aluvión de problemas y críticas de seguridad que tuvo la medida desde su presentación. De hecho, ahora los de Cupertino tratan de blanquear los problemas tratando de invertir en el origen, intentando evitar que la pornografía infantil se proudzca invirtiendo en otro tipo de medidas como la función Seguridad de las comunicaciones de iMessage.

December 9, 2022 at 01:00PM

SIGUENOS EN FACEBOOK: https://ift.tt/7BUMujo

SIGUENOS EN TWITTER: https://twitter.com/Techinford

via Actualidad iPhone https://ift.tt/v6zWaTf

Comentarios

Publicar un comentario